Najnowsze Wydania

-

GN 49/2025 Dokument:(9515780,Szlachetne ryby i morskie potwory)

-

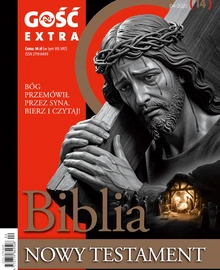

Gość Extra 4/2025 (14) Dokument:(9516809,Biblijna szkoła codzienności. Edytorial nowego wydania „Gościa Extra”)

-

GN 48/2025 Dokument:(9507866,Metoda na życie)

-

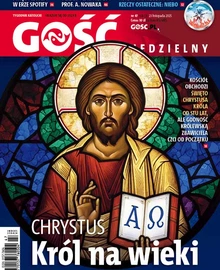

GN 47/2025 Dokument:(9498737,Mój król i moje królestwo)

-

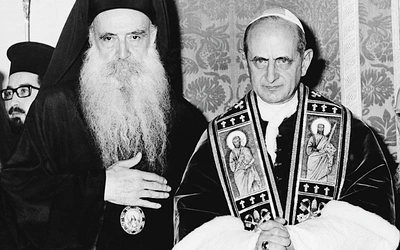

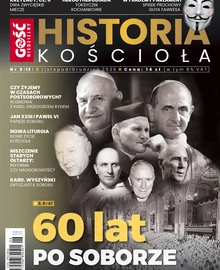

Historia Kościoła (12) 06/2025 Dokument:(9471760,Sobór sprawił, że ludzie znowu zaczęli mieć pytania do Kościoła. Edytorial nowego wydania)

Inteligencja w sądzie

Czy można sobie wyobrazić, żeby o tym, kto jest winny i na jaki wymiar kary zasługuje, decydował nie człowiek, tylko program komputerowy, sztuczna inteligencja? W sumie nie trzeba sobie tego wyobrażać. To już się dzieje. I są ku temu konkretne powody.

Nie twierdzę, że te powody są jednoznaczne i bezdyskusyjne. Ale też nie uważam, że są nic nieznaczące. W sumie cały problem sprowadza się do zastanowienia się, czym jest sprawiedliwość. Czy dwie różne osoby popełniające to samo wykroczenie albo przestępstwo powinny być karane w ten sam sposób? A może sprawiedliwsze jest wzięcie pod uwagę dotychczasowego życia sądzonego? Jak to wszystko wyważyć?

To dla nas sygnał, że cenisz rzetelne dziennikarstwo jakościowe. Czytaj, oglądaj i słuchaj nas bez ograniczeń.

Czytasz fragment artykułu

Subskrybuj i czytaj całość

już od 14,90 zł

Poznaj pełną ofertę SUBSKRYPCJI

Tomasz Rożek

Polecane w subskrypcji

-

- wychowanie

-

- Rozmowa

-

- Cykl „Gościa”

-

- Kościół